AI युद्ध: तकनीकी प्रगति और सैन्य रणनीतियों में बदलाव

1983 की फ़िल्म वॉर गेम्स में, WOPR (वॉर ऑपरेशन प्लान रिस्पॉन्स) के नाम से जाना जाने वाला एक सुपरकंप्यूटर संयुक्त राज्य अमेरिका और सोवियत संघ के बीच परमाणु युद्ध को भड़काने वाला है, लेकिन एक किशोर (मैथ्यू ब्रोडरिक द्वारा अभिनीत) की चतुराई के कारण, तबाही टल जाती है।

पहली टर्मिनेटर फ़िल्म में, जो एक साल बाद रिलीज़ हुई थी, “स्काईनेट” नामक एक सुपरकंप्यूटर मानवता को खत्म करने का फैसला करता है क्योंकि इसे अमेरिकी परमाणु हथियारों की रक्षा करने के बजाय इसके अस्तित्व के लिए खतरा माना जाता है।

हालाँकि इन फिल्मों ने दर्शकों को बुद्धिमान मशीनों के बेकाबू होने के भयावह परिदृश्य दिखाए, लेकिन वे भविष्यसूचक भी थे। आर्टिफिशियल इंटेलिजेंस (AI) इतना आम है कि इसे एक साधारण Google खोज के दौरान नियमित रूप से लागू किया जाता है। यह कोई आश्चर्य की बात नहीं है कि इसे सैन्य रणनीतियों में भी एकीकृत किया जा रहा है। यह सिर्फ इतना है कि हमें इन उच्च तकनीक वाले हथियारों (जो अब उपयोग के लिए तैयार हैं और जो विकास में हैं) की क्षमता के बारे में बहुत कम समझ है। न ही हम उन प्रणालियों के लिए तैयार हैं जो युद्ध को हमेशा के लिए बदलने की क्षमता रखती हैं।

पूरे इतिहास में, यह मानव बुद्धि है जो तकनीक का उपयोग करती है, न कि तकनीक ने, जिसने युद्ध जीते या हारे हैं। भविष्य में यह बदल सकता है जब मानव बुद्धि इसके बजाय ऐसी प्रणालियाँ बनाने पर केंद्रित होगी जो युद्ध के मैदान में विरोधी की तुलना में अधिक सक्षम हों।

एक “घातीय, दुर्गम आश्चर्य”

आर्टिफिशियल इंटेलिजेंस एक ऐसी तकनीक नहीं है जिसका आसानी से पता लगाया जा सके, निगरानी की जा सके या उस पर प्रतिबंध लगाया जा सके, जैसा कि AI कंपनी स्पार्ककॉग्निशन के संस्थापक और सीईओ आमिर हुसैन ने मीडिया न्यूज़ के लिए एक निबंध में बताया है। एआई तत्वों- दृश्य पहचान, भाषा विश्लेषण, सिमुलेशन-आधारित भविष्यवाणी, और खोज के उन्नत रूपों- को मौजूदा तकनीकों और प्लेटफ़ॉर्म के साथ एकीकृत करने से “पूरी तरह से नई और अप्रत्याशित क्षमताएँ प्राप्त हो सकती हैं।”

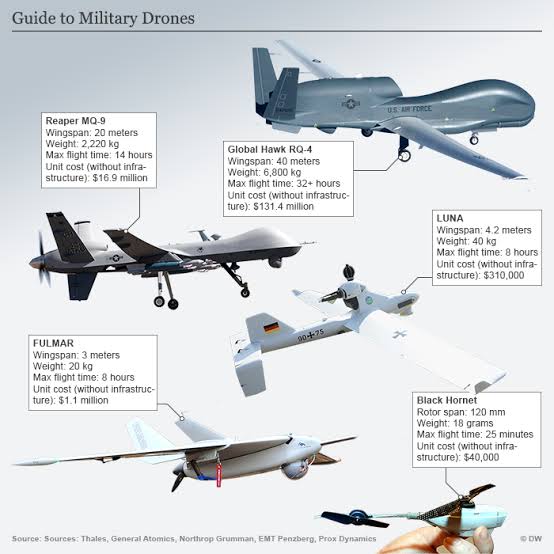

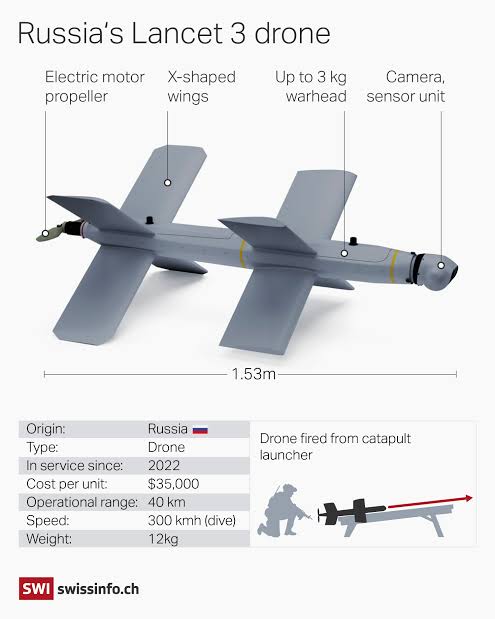

हुसैन लिखते हैं कि इसका परिणाम “घातीय, दुर्गम आश्चर्य पैदा कर सकता है।” युद्ध में उन्नत तकनीक पहले से ही व्यापक है। सैन्य सेटिंग्स में बिना चालक वाले हवाई वाहनों (यूएवी)- जिन्हें आमतौर पर ड्रोन के रूप में जाना जाता है- के उपयोग ने “हत्यारे रोबोट” के बारे में चेतावनी दी है। क्या होगा जब ड्रोन अब मनुष्यों द्वारा नियंत्रित नहीं होते हैं और अपने दम पर सैन्य मिशन को अंजाम दे सकते हैं? ये ड्रोन हवा तक ही सीमित नहीं हैं; वे जमीन पर या पानी के नीचे भी काम कर सकते हैं। एआई की शुरूआत, प्रभावी रूप से इन हथियारों को स्वायत्तता की क्षमता प्रदान करती है, जो बहुत दूर नहीं है। इसके अलावा, वे उत्पादन में सस्ते हैं और खरीदने में भी सस्ते हैं। रूसी यूक्रेन में अपने युद्ध में उपयोग के लिए ईरान से ड्रोन खरीद रहे हैं, और यूक्रेनियन रूसियों के खिलाफ अपने स्वयं के ड्रोन का निर्माण करके एक कुटीर उद्योग स्थापित कर रहे हैं। जिस सापेक्ष आसानी से एक वाणिज्यिक ड्रोन को सैन्य उपयोग के लिए एक ड्रोन में परिवर्तित किया जा सकता है, वह वाणिज्यिक और सैन्य उद्यमों के बीच की रेखा को भी धुंधला कर देता है। हालाँकि, इस बिंदु पर, मनुष्य अभी भी प्रभारी हैं।

सूचना-संग्रह प्रणालियों में भी ऐसी ही समस्या देखी जा सकती है, जिनके दोहरे उपयोग हैं, जिनमें उपग्रह, मानवयुक्त और मानवरहित विमान, ज़मीन और समुद्र के नीचे के रडार और सेंसर शामिल हैं, जिनमें से सभी के वाणिज्यिक और सैन्य दोनों अनुप्रयोग हैं। AI इन सभी प्रणालियों से बड़ी मात्रा में डेटा संसाधित कर सकता है और फिर सार्थक पैटर्न को पहचान सकता है, ऐसे परिवर्तनों की पहचान कर सकता है जिन्हें मनुष्य कभी नोटिस नहीं कर सकते। इराक और अफ़गानिस्तान में युद्धों में अमेरिकी सेनाएँ कुछ हद तक बाधित रहीं क्योंकि वे बड़ी मात्रा में डेटा संसाधित नहीं कर सकती थीं। अब भी, दूर से संचालित यूएवी स्वायत्त टेकऑफ़, लैंडिंग और नियमित उड़ान के लिए AI का उपयोग कर रहे हैं। मानव संचालकों के लिए बस इतना ही करना बाकी है कि वे सामरिक निर्णयों पर ध्यान केंद्रित करें, जैसे कि हमले के लक्ष्यों का चयन करना और हमलों को अंजाम देना।

AI इन प्रणालियों को तेज़ी से संचालित करने की अनुमति देता है, ऐसी गति से कार्रवाई निर्धारित करता है जो शायद ही कभी संभव हो अगर मनुष्य निर्णय लेने की प्रक्रिया का हिस्सा हों। अब तक, निर्णय लेने की गति युद्ध का सबसे महत्वपूर्ण पहलू रही है। हालाँकि, अगर AI सिस्टम मनुष्यों के खिलाफ़ आमने-सामने होते हैं, तो AI हमेशा आगे निकल जाएगा। हालांकि, यह संभावना कि एआई सिस्टम मानवीय कारक को खत्म कर देगा, उन लोगों को भयभीत करती है जो सेल्युलाइड पर दिखाए गए सर्वनाशकारी परिदृश्य को वास्तविकता में घटित होते नहीं देखना चाहते हैं।

स्वचालित बनाम स्वायत्त

“स्वायत्त” और “स्वचालित” शब्द के बीच अंतर किया जाना चाहिए। अगर हम ड्रोन को नियंत्रित कर रहे हैं, तो ड्रोन स्वचालित है। लेकिन अगर ड्रोन को अपनी पहल पर काम करने के लिए प्रोग्राम किया गया है, तो हम कहेंगे कि यह स्वायत्त है। लेकिन क्या स्वायत्त हथियार वास्तविक हथियार का वर्णन करता है – यानी ड्रोन पर मिसाइल – या ड्रोन खुद?

उदाहरण के लिए, ग्लोबल हॉक मिलिट्री यूएवी (ड्रोन) को ही लें। यह इस हद तक स्वचालित है कि इसे ज़मीन पर मौजूद एक ऑपरेटर द्वारा नियंत्रित किया जाता है, और फिर भी अगर यह ज़मीन से संपर्क खो देता है, तो गोल्डन हॉक अपने आप उतर सकता है। क्या यह इसे स्वचालित या स्वायत्त बनाता है? या यह दोनों है?

सबसे महत्वपूर्ण सवाल यह है कि क्या सिस्टम सुरक्षा के लिए महत्वपूर्ण है। इसका मतलब है कि क्या इसमें अपने मानव ऑपरेटर के हस्तक्षेप के बिना किसी लक्ष्य के खिलाफ़ हथियार का उपयोग करने की निर्णय लेने की क्षमता है। उदाहरण के लिए, यह संभव है कि ड्रोन अपने आप स्थिर सैन्य लक्ष्य (जैसे दुश्मन का सैन्य अड्डा) पर हमला कर सकता है, लेकिन किसी मानव लक्ष्य पर नहीं, क्योंकि उसे डर है कि इससे निर्दोष नागरिक घायल हो सकते हैं या मारे जा सकते हैं। कई देशों ने पहले से ही वास्तविक समय की छवियों के साथ ड्रोन विकसित किए हैं जो पहले उदाहरण में स्वायत्त रूप से कार्य करने में सक्षम हैं, लेकिन जब मानव लक्ष्यों की बात आती है तो ऐसा नहीं है।

ड्रोन एकमात्र हथियार नहीं हैं जो स्वायत्त रूप से कार्य कर सकते हैं। अमेरिका, चीन और यूरोप के कई देशों द्वारा सैन्य प्रणालियाँ विकसित की जा रही हैं जो अलग-अलग सफलता के साथ हवा, ज़मीन, पानी और पानी के भीतर स्वायत्त रूप से काम कर सकती हैं।

कई प्रकार के स्वायत्त हेलीकॉप्टर जिन्हें इस तरह से डिज़ाइन किया गया है कि एक सैनिक उन्हें स्मार्टफ़ोन के ज़रिए फ़ील्ड में निर्देशित कर सकता है, अमेरिका, यूरोप और चीन में विकास के चरण में हैं। स्वायत्त ज़मीनी वाहन, जैसे टैंक और परिवहन वाहन, और स्वायत्त पानी के नीचे के वाहन भी विकास के चरण में हैं। हालाँकि, लगभग सभी मामलों में, इन तकनीकों को विकसित करने वाली एजेंसियाँ विकास से परिचालन कार्यान्वयन तक की छलांग लगाने के लिए संघर्ष कर रही हैं।

इन तकनीकों को परिपक्वता तक लाने में सफलता की कमी के कई कारण हैं, जिनमें लागत और अप्रत्याशित तकनीकी मुद्दे शामिल हैं, लेकिन संगठनात्मक और सांस्कृतिक बाधाएँ भी उतनी ही समस्याग्रस्त हैं। उदाहरण के लिए, अमेरिका ने स्वायत्त यूएवी को परिचालन की स्थिति में लाने के लिए संघर्ष किया है, मुख्य रूप से संगठनात्मक अंतर्कलह और मानवयुक्त विमानों के पक्ष में प्राथमिकता के कारण।

भविष्य का योद्धा

भविष्य के युद्ध के मैदान में, कुलीन सैनिक एक हेड-अप डिस्प्ले पर भरोसा कर सकते हैं जो उन्हें ढेर सारी जानकारी देता है जिसे AI इंजन का उपयोग करके उनके बैकपैक में रखे सुपर कंप्यूटरों के माध्यम से एकत्र और रूट किया जाता है। AI के साथ, डेटा का तुरंत विश्लेषण किया जाता है, सुव्यवस्थित किया जाता है, और हेड-अप डिस्प्ले में वापस फीड किया जाता है। यह अमेरिकी रक्षा विभाग के अधिकारियों द्वारा प्रस्तुत कई संभावित परिदृश्यों में से एक है। पेंटागन ने एक अपेक्षाकृत सरल अवधारणा को अपनाया है: “हाइपर-सक्षम ऑपरेटर।”

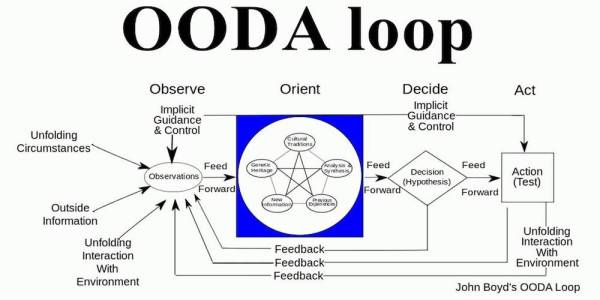

इस अवधारणा का उद्देश्य युद्ध के मैदान पर विशेष बलों को “संज्ञानात्मक ओवरमैच” देना है, या “प्रतिद्वंद्वी की तुलना में तेज़ी से सूचित निर्णय लेकर स्थिति पर हावी होने की क्षमता” देना है। दूसरे शब्दों में, वे अपने दुश्मन की तुलना में अधिक तेज़ी से प्राप्त होने वाली जानकारी के आधार पर निर्णय लेने में सक्षम होंगे। सेना के लिए निर्णय लेने के मॉडल को “OODA लूप” कहा जाता है, जिसका अर्थ है “निरीक्षण करना, उन्मुख करना, निर्णय लेना, कार्य करना।” यह उन कंप्यूटरों का उपयोग करके आएगा जो सभी प्रासंगिक डेटा को पंजीकृत करते हैं और उन्हें हेड-अप डिस्प्ले जैसे सरल इंटरफ़ेस के माध्यम से कार्रवाई योग्य जानकारी में परिवर्तित करते हैं।

यह डिस्प्ले एक “विज़ुअल एनवायरनमेंट ट्रांसलेशन” सिस्टम भी प्रदान करेगा, जिसे वास्तविक समय में विदेशी भाषा इनपुट को स्पष्ट अंग्रेजी में बदलने के लिए डिज़ाइन किया गया है। VITA के रूप में जाना जाने वाला यह सिस्टम विज़ुअल एनवायरनमेंट ट्रांसलेशन प्रयास और वॉयस-टू-वॉयस ट्रांसलेशन क्षमताओं दोनों को शामिल करता है। ट्रांसलेशन इंजन ऑपरेटर को “प्रभावी बातचीत में संलग्न होने की अनुमति देगा जहाँ यह पहले असंभव था।” VITA, जिसका अर्थ है वर्सेटाइल इंटेलिजेंट ट्रांसलेशन असिस्टेंट, उपयोगकर्ताओं को रूसी, यूक्रेनी और चीनी में भाषा क्षमताएँ प्रदान करता है, जिसमें मंदारिन, एक चीनी बोली भी शामिल है। उदाहरण के लिए, ऑपरेटर अपने स्मार्टफ़ोन का उपयोग किसी विदेशी देश की सड़क को स्कैन करने के लिए कर सकते हैं और तुरंत वास्तविक समय में सड़क के संकेतों का अनुवाद प्राप्त कर सकते हैं।

विरोधी AI सिस्टम सैन्य विशेषज्ञ विरोधी हमलों को चार श्रेणियों में विभाजित करते हैं: चोरी, अनुमान, जहर और निष्कर्षण। इस प्रकार के हमले आसानी से किए जा सकते हैं और अक्सर कंप्यूटिंग कौशल की आवश्यकता नहीं होती है। बचाव के हमलों में शामिल एक दुश्मन पता लगाने से बचने के लिए एक AI हथियार को धोखा देने का प्रयास कर सकता है – उदाहरण के लिए, एक साइबर हमले को छिपाना या एक सेंसर को यह विश्वास दिलाना कि एक टैंक एक स्कूल बस है। इसके लिए रणनीतिक टेप प्लेसमेंट जैसे नए प्रकार के AI छलावरण के विकास की आवश्यकता हो सकती है, जो AI को मूर्ख बना सकता है।

जब कोई विरोधी AI सिस्टम के बारे में जानकारी प्राप्त करता है, जो टालने की तकनीकों की अनुमति देता है, तो अनुमान हमले होते हैं। ज़हर के हमले प्रशिक्षण के दौरान AI सिस्टम को लक्षित करते हैं, सैन्य उपकरणों को प्रशिक्षित करने के लिए उपयोग किए जाने वाले डेटासेट तक पहुँच में बाधा डालते हैं – उदाहरण के लिए, लक्ष्यीकरण प्रणालियों को धोखा देने के लिए वाहनों की छवियों को गलत लेबल करना, या आसन्न सिस्टम विफलता को नियमित ऑपरेशन के रूप में वर्गीकृत करने के लिए डिज़ाइन किए गए रखरखाव डेटा में हेरफेर करना।

विभिन्न स्वायत्त सैन्य उपकरण

निष्कर्षण हमले AI के इंटरफ़ेस तक पहुँच का फ़ायदा उठाते हैं ताकि AI के संचालन के बारे में इतना कुछ सीखा जा सके कि सिस्टम का एक समानांतर मॉडल बनाया जा सके। अगर AI सिस्टम अनधिकृत उपयोगकर्ताओं से सुरक्षित नहीं हैं, तो विरोधी के उपयोगकर्ता उन सिस्टम द्वारा लिए गए निर्णयों की भविष्यवाणी कर सकते हैं और उन भविष्यवाणियों का अपने फ़ायदे के लिए इस्तेमाल कर सकते हैं।

उदाहरण के लिए, वे भविष्यवाणी कर सकते हैं कि AI-नियंत्रित मानव रहित सिस्टम विशिष्ट दृश्य और विद्युत चुम्बकीय उत्तेजनाओं पर कैसे प्रतिक्रिया देगा और फिर उसके मार्ग और व्यवहार को बदलने के लिए आगे बढ़ेगा। भ्रामक हमले तेज़ी से आम हो गए हैं, जैसा कि इमेज क्लासिफ़िकेशन एल्गोरिदम से जुड़े मामलों से स्पष्ट होता है, जो ऐसी छवियों को समझने में धोखा देते हैं जो वहाँ नहीं हैं, छवियों के अर्थ को भ्रमित करते हैं, और उदाहरण के लिए, कछुए को राइफ़ल समझ लेते हैं। इसी तरह, स्वायत्त वाहनों को गलत लेन में जाने या स्टॉप साइन के माध्यम से तेज़ी से आगे बढ़ने के लिए मजबूर किया जा सकता है।

2019 में, चीन ने एक नई सैन्य रणनीति, इंटेलिजेंटाइज़्ड वारफेयर की घोषणा की, जो AI का उपयोग करती है। चीनी पीपुल्स लिबरेशन आर्मी के अधिकारियों ने कहा है कि उनकी सेना AI का उपयोग करके अमेरिकी सेना से आगे निकल सकती है। इसका एक उद्देश्य इस उच्च तकनीक वाले युद्ध का उपयोग करके पारंपरिक युद्ध किए बिना ताइवान को अपने नियंत्रण में लाना है। हालाँकि, बुद्धिमान युद्ध पर कई चीनी अध्ययनों में से केवल कुछ ने बंदूकों को AI से बदलने पर ध्यान केंद्रित किया है। दूसरी ओर, चीनी रणनीतिकारों ने दुश्मन की इच्छा को सीधे नियंत्रित करने के अपने इरादे को छिपाया नहीं है। इसमें अमेरिकी राष्ट्रपति, कांग्रेस के सदस्य, लड़ाकू कमांडर और नागरिक शामिल होंगे। “खुफिया प्रभुत्व” – जिसे संज्ञानात्मक युद्ध या “मस्तिष्क का नियंत्रण” के रूप में भी जाना जाता है – को बुद्धिमान युद्ध में नए युद्ध के मैदान के रूप में देखा जाता है, जो AI को अधिकांश अमेरिकी और सहयोगी चर्चाओं की तुलना में बहुत अलग उपयोग में लाता है।

चीनी सैन्य विकास पर पेंटागन की 2022 की रिपोर्ट के अनुसार, पीपुल्स लिबरेशन आर्मी को AI-सक्षम सेंसर और कंप्यूटर नेटवर्क का उपयोग करने के लिए प्रशिक्षित और सुसज्जित किया जा रहा है ताकि “अमेरिकी परिचालन प्रणाली में प्रमुख कमजोरियों की तेजी से पहचान की जा सके और फिर उन कमजोरियों के खिलाफ सटीक हमले शुरू करने के लिए डोमेन में संयुक्त बलों को जोड़ा जा सके।” किसी विरोधी के दिमाग को नियंत्रित करने से न केवल किसी व्यक्ति की अपने आस-पास की चीज़ों के बारे में धारणाएँ प्रभावित हो सकती हैं, बल्कि अंततः उसके फ़ैसलों पर भी असर पड़ सकता है। पीपुल्स लिबरेशन आर्मी के लिए, संज्ञानात्मक युद्ध संघर्ष के अन्य क्षेत्रों के बराबर है, जो वायु, भूमि और समुद्र हैं। इस संबंध में, सोशल मीडिया को एक महत्वपूर्ण युद्धक्षेत्र माना जाता है। रूस भी अपनी खुद की AI क्षमता विकसित कर रहा है। 2014 की शुरुआत में, रूसियों ने मॉस्को में एक राष्ट्रीय रक्षा नियंत्रण केंद्र का उद्घाटन किया, जो वैश्विक खतरों का आकलन करने और उनका जवाब देने के लिए एक केंद्रीकृत कमांड पोस्ट है। केंद्र को कई स्रोतों से दुश्मन की हरकतों के बारे में जानकारी एकत्र करने और वरिष्ठ अधिकारियों को संभावित प्रतिक्रियाओं पर मार्गदर्शन प्रदान करने के लिए डिज़ाइन किया गया था।

रूस ने घोषणा की है कि वह अंततः दुनिया को चलाने में सक्षम एक AI सिस्टम विकसित करेगा। रूसी पहले से ही यूक्रेन में AI का उपयोग कर रहे हैं ताकि यूक्रेनी ड्रोन को उन उपग्रहों से जोड़ने वाले वायरलेस सिग्नल को जाम किया जा सके जिन पर वे नेविगेशन के लिए निर्भर हैं, जिससे मशीनें अपना रास्ता खो देती हैं और धरती पर गिर जाती हैं। रूसी रक्षा मंत्रालय (MOD) ने उन तरीकों की खोज की है जिनसे हवा, समुद्री और ज़मीनी डोमेन के लिए बिना चालक वाले सिस्टम के लिए AI सिस्टम विकसित किए जा सकते हैं। साथ ही, कम से कम अल्पावधि में, आधिकारिक नीति इस विश्वास पर आधारित है कि मनुष्यों को दृढ़ता से लूप में रहना चाहिए।

इस बीच, रूसी कमांड, नियंत्रण और संचार के लिए एक तंत्र के रूप में AI के साथ UAV क्षमताओं को बेहतर बनाने की कोशिश कर रहे हैं। MOD वर्तमान “डिजिटल” लड़ाकू प्रौद्योगिकी और सिस्टम विकास से एक प्राकृतिक विकास के रूप में डेटा संग्रह और विश्लेषण के लिए AI के उपयोग पर भी जोर देता है।

AI से संचालित ‘रेवेन सेंट्री’: अफ़गानिस्तान में अमेरिकी सैन्य रणनीति में क्रांतिकारी बदलाव

अमेरिकी खुफिया द्वारा युद्ध के मैदान में AI का उपयोग, हालांकि संक्षिप्त, आशाजनक परिणाम दिखाता है। 2019 में अमेरिकी खुफिया अधिकारियों (जिन्हें “नर्ड लॉकर” के नाम से जाना जाता है) की एक टीम द्वारा सिलिकॉन वैली के विशेषज्ञों की मदद से लॉन्च किया गया “रेवेन सेंट्री” एक एआई टूल है, जिसका उद्देश्य विद्रोही हमलों की भविष्यवाणी करना था। एआई का प्रारंभिक उपयोग ऐसे समय में हुआ जब अमेरिकी ठिकाने बंद हो रहे थे, सैनिकों की संख्या घट रही थी और खुफिया संसाधनों को डायवर्ट किया जा रहा था। रेवेन सेंट्री ओपन-सोर्स डेटा पर निर्भर था।

जुलाई 2019 से जुलाई 2020 तक अफगानिस्तान के काबुल में रेसोल्यूट सपोर्ट जे2 खुफिया मिशन के चीफ ऑफ स्टाफ कर्नल थॉमस स्पाहर कहते हैं, “हमने वाणिज्यिक उपग्रहों की बढ़ती संख्या और इंटरनेट पर समाचार रिपोर्टों की उपलब्धता, सोशल मीडिया पोस्टिंग के प्रसार और बड़ी संख्या में सदस्यता वाले मैसेजिंग ऐप द्वारा प्रस्तुत अवसर को देखा।” एआई टूल ने अफगानिस्तान में 40 साल पहले की विद्रोही गतिविधियों के आधार पर ऐतिहासिक पैटर्न को भी अपनाया। पर्यावरणीय कारकों पर भी विचार किया गया। स्पाहर कहते हैं, “ऐतिहासिक रूप से, विद्रोही साल के कुछ दिनों या छुट्टियों पर, उदाहरण के लिए, या कुछ खास मौसम और रोशनी की स्थिति में हमला करते हैं।” उन्होंने आगे कहा, “AI की खूबसूरती यह है कि यह उस टेम्पलेट को लगातार अपडेट करता रहता है। मशीन जैसे-जैसे अधिक डेटा अवशोषित करेगी, सीखती जाएगी।”

2021 में इसके खत्म होने से पहले (अफ़गानिस्तान से अमेरिका की वापसी के साथ), रेवेन सेंट्री ने 70% सटीकता के साथ विद्रोही हमले की भविष्यवाणी करते हुए इसकी व्यवहार्यता का प्रदर्शन किया था। AI टूल ने भविष्यवाणी की थी कि जब तापमान 4 डिग्री सेल्सियस (या 39.2 डिग्री फ़ारेनहाइट) से ऊपर होता है, जब चंद्रमा की रोशनी 30% से कम होती है, और जब बारिश नहीं होती है, तो हमले होने की अधिक संभावना होती है। स्पाहर परिणामों से संतुष्ट थे: “हमने पुष्टि की कि व्यावसायिक रूप से उत्पादित, अवर्गीकृत जानकारी से भविष्यसूचक खुफिया जानकारी मिल सकती है।”

यूक्रेन में AI तकनीकों की कसौटी परख: भविष्य के युद्धों की झलक

2022 में शुरू किए गए रूसी आक्रमण के बाद से, यूक्रेन युद्ध में AI के लिए एक परीक्षण स्थल बन गया है। कमज़ोर और कमज़ोर यूक्रेनी सेना ने उन्हें घातक स्वायत्त हथियारों में बदलने के लिए कामचलाऊ, जेरी-रिगिंग ऑफ़-द-शेल्फ़ उपकरणों का सहारा लिया है। रूसी आक्रमणकारियों ने भी साइबर हमले और जीपीएस-जैमिंग सिस्टम का संचालन करते हुए एआई का इस्तेमाल किया है।

यूक्रेन के सैकर स्काउट क्वाडकॉप्टर “64 प्रकार की रूसी ‘सैन्य वस्तुओं’ को अपने आप खोज सकते हैं, पहचान सकते हैं और उन पर हमला कर सकते हैं।” इन ड्रोन को स्वायत्त रूप से संचालित करने के लिए डिज़ाइन किया गया है, और यूक्रेनी सेना द्वारा तैनात अन्य ड्रोन के विपरीत, रूस उन्हें जाम नहीं कर सकता है।

ऑनलाइन पाए जाने वाले कोड और हार्डवेयर स्टोर से आसानी से प्राप्त रास्पबेरी पाई जैसे शौकिया कंप्यूटर का उपयोग करके, यूक्रेन के लोग अभिनव हत्यारे रोबोट बनाने में सक्षम हैं। ड्रोन के अलावा, जिसे स्मार्टफोन से संचालित किया जा सकता है, यूक्रेन के लोगों ने एक गन बुर्ज बनाया है जिसमें स्वायत्त लक्ष्यीकरण है जो प्लेस्टेशन या टैबलेट द्वारा उपयोग किए जाने वाले समान नियंत्रक से संचालित होता है। गन, जिसे वॉली कहा जाता है क्योंकि यह पिक्सर रोबोट WALL-E से मिलती जुलती है, 1,000 मीटर (3,280 फीट) दूर तक के लक्ष्य पर ऑटो-लॉक कर सकती है और एक व्यापक क्षेत्र को जल्दी से कवर करने के लिए पूर्व-प्रोग्राम किए गए पदों के बीच शिफ्ट हो सकती है।

निर्माता एक ऐसी बंदूक भी विकसित कर रहा है जो गतिशील लक्ष्यों को मार सके। यह क्षितिज पर आने वाले लक्ष्यों को स्वचालित रूप से पहचान सकता है। बंदूक स्वचालित रूप से लक्ष्य बनाती है और निशाना लगाती है; ऑपरेटर को बस बटन दबाना है और गोली चलानी है। कई यूक्रेनी ड्रोन, जो वॉलमार्ट में मिलने वाले ड्रोन जैसे दिखते हैं, उन्हें फर्स्ट पर्सन व्यू (FPV) ड्रोन कहा जाता है। 100 मील प्रति घंटे की गति से उड़ान भरने में सक्षम, FPV ड्रोन में चार प्रोपेलर और एक माउंटेड कैमरा होता है जो ऑपरेटरों को उनकी उड़ानों की फुटेज वापस भेजने के लिए वायरलेस का उपयोग करता है। बोर्ड पर बम के साथ, एक FPV को एक हथियार में परिवर्तित किया जा सकता है जो एक टैंक को नष्ट कर सकता है। वे सस्ते भी हैं; एक निर्माता, व्यरी, प्रत्येक के लिए $400 लेता है, जो लाखों डॉलर के टैंक को निष्क्रिय करने के लिए चुकाई जाने वाली एक छोटी सी कीमत है। व्यरी का नाम स्लाविक लोककथाओं में एक पौराणिक भूमि से लिया गया है।

यदि एक कामिकेज़ ड्रोन अच्छा है, तो उनमें से दर्जनों बेहतर हैं क्योंकि उनकी संख्या जितनी अधिक होगी, उतनी ही अधिक संभावना है कि कई अपने लक्ष्य तक पहुँचेंगे। प्रकृति में, चींटियों का झुंड एक जीवित जीव की तरह व्यवहार करता है, चाहे कार्य भोजन इकट्ठा करना हो या घोंसला बनाना हो। इसी तरह, स्वायत्त ड्रोन का झुंड एक जीव की तरह काम कर सकता है – किसी इंसान की ज़रूरत नहीं – चाहे कितने भी अक्षम हो जाएँ या ज़मीन पर गिर जाएँ या ज़मीन से संचार बाधित हो या समाप्त हो जाए।

हालाँकि मनुष्य अभी भी “लूप” में हैं, लेकिन इन हथियारों को पूरी तरह से स्वायत्त बनाया जा सकता है। दूसरे शब्दों में, वे तय कर सकते हैं कि मानवीय हस्तक्षेप के बिना किस लक्ष्य पर हमला करना है।

ऐसा नहीं है कि यूक्रेन ने बिना किसी तकनीकी अनुभव के AI हथियार अपनाए हैं। न्यूयॉर्क टाइम्स के रिपोर्टर पॉल मोजर के शब्दों में, “यूक्रेन लंबे समय से वैश्विक प्रौद्योगिकी उद्योग के लिए एक तरह से बैक ऑफिस रहा है।” देश में पहले से ही कोडर्स और कुशल विशेषज्ञों का एक बड़ा समूह था, जो आपातकालीन परिस्थितियों में नागरिक उपयोग (जैसे डेटिंग ऐप) से सैन्य उद्देश्यों में बदलाव करने में सक्षम थे। जैसा कि मोजर ने बताया: “वे जो कर रहे हैं, वह यह है कि वे आस-पास मौजूद बुनियादी कोड को लेकर, उसे युद्ध से मिले कुछ नए डेटा के साथ मिलाकर, उसे पूरी तरह से अलग चीज़ में बदल रहे हैं, जो एक हथियार है।”

वास्तविकता यह है कि, “बड़ी रक्षा कंपनियों में बहुत सारी शानदार, रोमांचक चीज़ें हो रही हैं,” युद्ध और तकनीक के बारे में लिखने वाले लेखक पी.डब्ल्यू. सिंगर कहते हैं। “बड़ी-तकनीक वाली सिलिकॉन वैली कंपनियों में बहुत सारी शानदार, रोमांचक चीज़ें हो रही हैं। छोटे स्टार्टअप में बहुत सारी शानदार, रोमांचक चीज़ें हो रही हैं।”

ऐसी ही एक छोटी स्टार्टअप है एंडुरिल। लोकप्रिय वर्चुअल रियलिटी हेडसेट ओकुलस को फेसबुक (अब मेटा) को बेचने के बाद, तीस के दशक की शुरुआत में उद्यमी पामर लुकी ने एक एआई हथियार कंपनी की स्थापना की जो यूक्रेन को ड्रोन की आपूर्ति कर रही है। वे कहते हैं, “यूक्रेन सीखने के लिए बहुत चुनौतीपूर्ण वातावरण है।” “मैंने खुद यूक्रेन के लोगों से कई अनुमान सुने हैं कि किसी भी ड्रोन का जीवनकाल आम तौर पर लगभग चार सप्ताह का होता है। सवाल यह है कि, “क्या आप प्रतिक्रिया दे सकते हैं और अनुकूलन कर सकते हैं?” एंडुरिल, जिसका नाम द लॉर्ड ऑफ द रिंग्स में एक तलवार के नाम पर रखा गया है, ने अपने उपकरण अमेरिका सहित 10 देशों को बेचे हैं।

“मुझे यह विश्वास था कि प्रमुख रक्षा कंपनियों के पास कृत्रिम बुद्धिमत्ता, स्वायत्तता, रोबोटिक्स जैसी चीज़ों में निवेश करने के लिए सही प्रतिभा या सही प्रोत्साहन संरचना नहीं है,” लुकी कहते हैं। उनकी कंपनी के ड्रोन, जिसे ALTIUS कहा जाता है, को एक ट्यूब से बाहर निकाल कर अपने पंखों और पूंछ को फैलाकर खुद को खोलने का इरादा है; फिर, एक प्रोपेलर के साथ स्टीयरिंग करते हुए, यह 30 पाउंड के वारहेड को ले जाने में सक्षम विमान की तरह काम करता है। लुकी का मानना है कि उनके दृष्टिकोण के परिणामस्वरूप कम समय में और कम लागत पर अधिक AI हथियार बनाए जा सकेंगे, जो मैकडॉनेल डगलस जैसे पारंपरिक रक्षा ठेकेदारों द्वारा हासिल किए जा सकते हैं।

2017 में स्थापित एंडुरिल, डाइव-एलडी भी विकसित कर रहा है, एक ड्रोन जिसका उपयोग तटीय और गहरे पानी में सर्वेक्षण के लिए किया जाएगा। “यह एक स्वायत्त पानी के नीचे का वाहन है जो बहुत लंबी दूरी तक जाने में सक्षम है, लगभग 6,000 मीटर की गहराई तक गोता लगा सकता है (लगभग 20,000 फीट) की गहराई, जो लगभग किसी भी महासागर की तलहटी तक जाने के लिए पर्याप्त है,” लुकी कहते हैं। यूक्रेन पहले से ही अपने समुद्री ड्रोन बना रहा है – मूल रूप से विस्फोटकों से भरे जेट स्की – जिन्होंने काले सागर में रूसी नौसेना को गंभीर नुकसान पहुंचाया है।

जैसा कि एंडुरिल के सीईओ ब्रायन शिम्पफ मानते हैं, यूक्रेन में एंडुरिल के ड्रोन की शुरूआत से अभी तक कोई महत्वपूर्ण परिणाम नहीं मिले हैं, हालांकि उनका मानना है कि इसमें बदलाव आएगा। एक बार लॉन्च होने के बाद, इन ड्रोन को ज़मीन पर मौजूद ऑपरेटर के मार्गदर्शन की ज़रूरत नहीं होगी, जिससे रूसियों के लिए उनके सिग्नल जाम करके उन्हें नष्ट करना या निष्क्रिय करना मुश्किल हो जाएगा।

लुकी कहते हैं, “इसमें मौजूद स्वायत्तता ही इसे अलग बनाती है।” “यह रिमोट से नियंत्रित विमान नहीं है। इसमें एक मस्तिष्क है जो लक्ष्यों की तलाश करने, लक्ष्यों की पहचान करने और उन लक्ष्यों तक उड़ान भरने में सक्षम है।” हालाँकि, यूक्रेन द्वारा विकसित हर अभिनव हथियार प्रणाली के लिए, रूसी इसका मुकाबला एक ऐसी प्रणाली से करते हैं जो इसे बेकार कर देती है। हूवर इंस्टीट्यूशन में फेलो के रूप में सैन्य प्रौद्योगिकी का अध्ययन करने वाली जैकलीन श्नाइडर कहती हैं, “कुछ महीने पहले तक जो तकनीकें वास्तव में अच्छी तरह से काम करती थीं, उन्हें अब लगातार बदलना पड़ रहा है, और मुझे जो बड़ा अंतर दिखाई देता है वह यह है कि सॉफ़्टवेयर परिवर्तन की दर को बदल देता है।”

गाजा में युद्ध: लैवेंडर

गाजा पर अपने आक्रमण में, इज़राइल रक्षा बलों (IDF) ने हमास के गुर्गों को निशाना बनाने के लिए कृत्रिम बुद्धिमत्ता द्वारा समर्थित एक कार्यक्रम पर तेजी से भरोसा किया है, जिसके परिणाम समस्याग्रस्त हैं। +972 मैगज़ीन (एक इज़राइली-फिलिस्तीनी प्रकाशन) और हिब्रू भाषा की समाचार साइट लोकल कॉल की अप्रैल 2024 की रिपोर्ट के अनुसार, IDF “लैवेंडर” नामक एक कार्यक्रम को लागू कर रहा है, जिसका सैन्य अभियानों पर इतना गहरा प्रभाव है कि खुफिया अधिकारियों ने अनिवार्य रूप से AI मशीन के आउटपुट को “ऐसा माना है जैसे कि यह एक मानवीय निर्णय हो।”

लैवेंडर को एलीट यूनिट 8200 द्वारा विकसित किया गया था, जो अमेरिका में राष्ट्रीय सुरक्षा एजेंसी या यूके में सरकारी संचार मुख्यालय के बराबर है।

इजरायल सरकार ने लैवेंडर की व्यावहारिकता और दक्षता के लिए उसका बचाव किया है। “इजरायली सेना मानव ऑपरेटरों की निर्णय लेने की प्रक्रियाओं को बढ़ाने के लिए एआई का उपयोग करती है। यह उपयोग अंतर्राष्ट्रीय मानवीय कानून के अनुसार है, जैसा कि आधुनिक सशस्त्र बलों द्वारा 11 सितंबर, 2001 से कई विषम युद्धों में लागू किया गया है,” टीएमसी एसर इंस्टीट्यूट में शोधकर्ता और विघटनकारी प्रौद्योगिकियों और सैन्य कानून के बीच अंतरसंबंध में विशेषज्ञ मैग्डा पचोलस्का कहती हैं।

लैवेंडर को विकसित करने के लिए इस्तेमाल किए गए उग्रवादियों की पहचान करने के लिए एकत्र किया गया डेटा गाजा पट्टी के 2.3 मिलियन से अधिक निवासियों से आता है, जो 2023 में गाजा पर आक्रमण से पहले गहन निगरानी में था।

रिपोर्ट में कहा गया है कि 37,000 से अधिक फिलिस्तीनियों को संदिग्ध उग्रवादियों के रूप में नामित किया गया था जिन्हें संभावित लक्ष्य के रूप में चुना गया था। लैवेंडर की हत्या सूची आक्रमण से पहले ही तैयार कर ली गई थी, जो 7 अक्टूबर 2023 के हमास हमले के जवाब में शुरू किया गया था, जिसमें लगभग 1,200 लोग मारे गए थे और लगभग 250 इजरायली बंधकों को ले जाया गया था।

एक संबंधित AI प्रोग्राम, जो लैवेंडर सूची में व्यक्तियों की गतिविधियों को ट्रैक करता था, को “व्हेयर इज डैडी?” कहा जाता था। +972 पत्रिका की रिपोर्ट के सूत्रों ने कहा कि शुरू में, “इस बात की पूरी तरह से जांच करने की कोई आवश्यकता नहीं थी कि मशीन ने उन (लक्ष्यों के) विकल्पों को क्यों चुना या कच्चे खुफिया डेटा की जांच करने की आवश्यकता नहीं थी जिस पर वे आधारित थे।” इन स्रोतों ने कहा कि प्रभारी अधिकारी बमबारी को अधिकृत करने से पहले मशीन के निर्णयों के लिए “रबर स्टैम्प” के रूप में कार्य करते थे।

+972 से बात करने वाले एक खुफिया अधिकारी ने भी इस बात को स्वीकार किया: “मैं इस स्तर पर प्रत्येक लक्ष्य के लिए 20 सेकंड का निवेश करूंगा, और हर दिन दर्जनों ऐसे लक्ष्य बनाऊंगा। एक इंसान के रूप में मेरे पास अनुमोदन की मुहर के अलावा कोई अतिरिक्त मूल्य नहीं था। इससे बहुत समय की बचत हुई।”

यह पहले से ही ज्ञात था कि लैवेंडर कार्यक्रम ने 10% मामलों में गलतियाँ कीं, जिसका अर्थ है कि लक्ष्य के रूप में चुने गए व्यक्तियों के एक अंश का हमास या किसी अन्य आतंकवादी समूह से कोई संबंध नहीं हो सकता है। हमले आम तौर पर रात में होते थे, जब लक्षित व्यक्ति घर पर होने की अधिक संभावना होती थी, जिससे उनके परिवारों के मारे जाने या घायल होने का जोखिम भी होता था।

प्रत्येक व्यक्ति के लिए 1 से 100 तक का स्कोर बनाया गया था, जो इस बात पर आधारित था कि वह हमास या इस्लामिक जिहाद के सशस्त्र विंग से कितना जुड़ा हुआ था। उच्च स्कोर वाले लोगों को उनके परिवारों और पड़ोसियों के साथ मार दिया गया, इस तथ्य के बावजूद कि अधिकारियों ने कथित तौर पर लैवेंडर द्वारा पहचाने गए संभावित लक्ष्यों को सत्यापित करने के लिए बहुत कम किया, “दक्षता” कारणों का हवाला देते हुए। लैवेंडर का उपयोग करने वाले एक खुफिया अधिकारी ने कहा, “यह मेरी याद में अद्वितीय है,” उन्होंने कहा कि उनके सहयोगियों को एक शोकग्रस्त सैनिक की तुलना में “सांख्यिकीय तंत्र” पर अधिक विश्वास था। “वहां मौजूद सभी लोगों ने, जिनमें मैं भी शामिल हूं, 7 अक्टूबर को लोगों को खो दिया। मशीन ने इसे ठंडे दिमाग से किया। और इससे यह आसान हो गया।”

IDF ने पहले “द गॉस्पेल” नामक एक अन्य AI सिस्टम का इस्तेमाल किया था, जिसका वर्णन पत्रिका द्वारा पिछली जांच में किया गया था, साथ ही साथ इजरायली सेना के अपने प्रकाशनों में भी, आतंकवादियों को पनाह देने के संदेह में इमारतों और संरचनाओं को निशाना बनाने के लिए किया गया था।

“द गॉस्पेल” लाखों डेटा आइटम पर आधारित है, जो मानव खुफिया अधिकारियों की टीम की तुलना में 50 गुना अधिक तेज़ी से लक्ष्य सूची तैयार करता है। इसका उपयोग गाजा की लड़ाई के पहले दो महीनों में प्रतिदिन 100 लक्ष्यों पर हमला करने के लिए किया गया था, जो एक दशक पहले इसी तरह के संघर्ष की तुलना में लगभग पाँच गुना अधिक था। हमास के लिए राजनीतिक या सैन्य महत्व के उन ढाँचों को “पावर टारगेट” के रूप में जाना जाता है।

AI हथियारों की तकनीकी और नैतिक चुनौतियाँ

यदि कोई AI हथियार स्वायत्त है, तो उसमें सटीक धारणा की क्षमता होनी चाहिए। इसका मतलब यह है कि अगर यह किसी नागरिक कार को सैन्य लक्ष्य समझ लेता है, तो इसकी प्रतिक्रिया दर प्रासंगिक नहीं होती। कार में मौजूद नागरिक मर जाते हैं। बेशक, कई मामलों में, AI सिस्टम धारणा में उत्कृष्ट रहे हैं क्योंकि AI-संचालित मशीनें और एल्गोरिदम परिष्कृत हो गए हैं। उदाहरण के लिए, जब रूसी सेना ने एकीकृत विज़ुअलाइज़ेशन के साथ सीरियाई युद्धक्षेत्रों पर एक साथ 80 UAV का परीक्षण किया, तो तत्कालीन रूसी रक्षा मंत्री सर्गेई शोइगु ने इसकी तुलना एक “अर्ध-शानदार फिल्म” से की, जिसमें सभी संभावित लक्ष्यों का पता चलता है।

लेकिन समस्याएँ आ सकती हैं। AI हथियार डिज़ाइन करने में, डेवलपर्स को सबसे पहले डेटा तक पहुँच की आवश्यकता होती है। कई AI सिस्टम को डेटा का उपयोग करके प्रशिक्षित किया जाता है जिसे एक विशेषज्ञ प्रणाली (जैसे, एयर डिफेंस बैटरी को शामिल करने वाले दृश्यों को लेबल करना) द्वारा लेबल किया गया है, आमतौर पर एक मानव। एक AI की छवि-प्रसंस्करण क्षमता तब अच्छी तरह से काम नहीं करेगी जब उसे ऐसी छवियाँ दी जाएँ जो उसके प्रशिक्षण सेट से अलग हों – उदाहरण के लिए, ऐसी तस्वीरें जहाँ प्रकाश की स्थिति खराब हो, जो एक अधिक कोण पर हों, या जो आंशिक रूप से अस्पष्ट हों। AI पहचान प्रणाली यह नहीं समझती कि छवि क्या है; इसके बजाय, वे छवि के पिक्सेल के बनावट और ढाल सीखते हैं। इसका मतलब है कि एक AI सिस्टम किसी छवि के एक हिस्से को सही ढंग से पहचान सकता है लेकिन उसकी संपूर्णता को नहीं, जिसके परिणामस्वरूप गलत वर्गीकरण हो सकता है। भ्रामक छवियों के खिलाफ AI का बेहतर बचाव करने के लिए, इंजीनियर उन्हें “प्रतिकूल प्रशिक्षण” के अधीन करते हैं। इसमें एक क्लासिफायर को प्रतिकूल छवियां खिलाना शामिल है ताकि वह उन लोगों की पहचान कर सके और उन्हें अनदेखा कर सके जिन्हें लक्षित नहीं किया जा रहा है।

पेंसिल्वेनिया स्टेट यूनिवर्सिटी के स्नातक छात्र निकोलस पेपरनॉट द्वारा किए गए शोध से पता चलता है कि प्रतिकूल प्रशिक्षण द्वारा समर्थित एक प्रणाली, छवियों की विशाल संख्या से अभिभूत होने पर अप्रभावी हो सकती है। प्रतिकूल छवियाँ कई AI सिस्टम में पाई जाने वाली एक विशेषता का लाभ उठाती हैं जिसे “निर्णय सीमाएँ” के रूप में जाना जाता है। ये सीमाएँ अदृश्य नियम हैं जो किसी सिस्टम को निर्देश देते हैं कि वह शेर को देख रहा है या तेंदुआ को। इसका उद्देश्य एक मानसिक मानचित्र बनाना होगा जिसमें एक सेक्टर में शेर और दूसरे में तेंदुए हों। इन दो सेक्टरों को विभाजित करने वाली रेखा – वह सीमा जिस पर शेर तेंदुआ बन जाता है या तेंदुआ शेर बन जाता है – को निर्णय सीमा के रूप में जाना जाता है। जेफ क्लून, जिन्होंने प्रतिकूल प्रशिक्षण का भी अध्ययन किया है, ऐसे वर्गीकरण प्रणालियों के बारे में संदिग्ध बने हुए हैं क्योंकि वे बहुत मनमानी हैं। “आप इन नेटवर्क के साथ जो कुछ भी कर रहे हैं वह उन्हें डेटा के समूहों के बीच रेखाएँ खींचने के लिए प्रशिक्षित करना है, बजाय इसके कि गहराई से मॉडलिंग की जाए कि [एक] तेंदुआ या शेर होना क्या है।”

बड़े डेटासेट को अक्सर उन कंपनियों द्वारा लेबल किया जाता है जो मैन्युअल तरीके अपनाती हैं। डेटासेट प्राप्त करना और साझा करना एक चुनौती है, खासकर ऐसे संगठन के लिए जो डेटा को वर्गीकृत करना और उस तक पहुँच को प्रतिबंधित करना पसंद करता है। उदाहरण के लिए, एक सैन्य डेटासेट में थर्मल-इमेजिंग सिस्टम द्वारा उत्पादित छवियाँ हो सकती हैं, लेकिन जब तक यह डेटासेट डेवलपर्स के साथ साझा नहीं किया जाता है, तब तक एक AI हथियार उतना प्रभावी नहीं होगा। उदाहरण के लिए, सैकड़ों शब्दों तक सीमित चैटबॉट पर निर्भर रहने वाले AI डिवाइस बहुत बड़ी शब्दावली वाले इंसान की जगह पूरी तरह से नहीं ले पाएँगे।

AI सिस्टम मल्टीटास्क करने में असमर्थ होने के कारण भी बाधित होते हैं। एक इंसान दुश्मन के वाहन की पहचान कर सकता है, उसके खिलाफ़ इस्तेमाल करने के लिए हथियार प्रणाली पर निर्णय ले सकता है, उसके मार्ग की भविष्यवाणी कर सकता है और फिर लक्ष्य पर हमला कर सकता है। एक AI सिस्टम इन चरणों को दोहरा नहीं सकता है। इस बिंदु पर, एक T-90 टैंक की पहचान करने के लिए प्रशिक्षित सिस्टम सबसे अधिक संभावना एक चीनी टाइप 99 टैंक की पहचान करने में असमर्थ होगा, इस तथ्य के बावजूद कि वे दोनों टैंक हैं और दोनों कार्यों के लिए छवि पहचान की आवश्यकता होती है। कई शोधकर्ता सिस्टम को उनके सीखने को स्थानांतरित करने में सक्षम बनाने के लिए काम करके इस समस्या को हल करने की कोशिश कर रहे हैं, लेकिन ऐसे सिस्टम उत्पादन से कई साल दूर हैं।

अनुमानतः, विरोधी छवि पहचान इंजन और सेंसर को धोखा देकर इन कमज़ोरियों का फ़ायदा उठाने की कोशिश करेंगे। वे घुसपैठ का पता लगाने वाले सिस्टम से बचने के लिए साइबर हमले करने की कोशिश भी कर सकते हैं या AI सिस्टम को बदला हुआ डेटा खिला सकते हैं जो उन्हें झूठी ज़रूरतें पूरी करेगा।

अमेरिकी तैयारी

अमेरिकी रक्षा विभाग नई तकनीकों को लागू करने की तुलना में हार्डवेयर के लिए अनुबंध करने और निर्माण करने में ज़्यादा पक्षपाती रहा है। फिर भी, वायु सेना, बोइंग, जनरल एटॉमिक्स और क्रेटोस नामक एक कंपनी के सहयोग से AI-संचालित ड्रोन विकसित कर रही है। वायु सेना कृत्रिम बुद्धिमत्ता द्वारा संचालित पायलट रहित XQ-58A Valkyrie प्रायोगिक विमान का भी परीक्षण कर रही है। यह अगली पीढ़ी का ड्रोन एक प्रोटोटाइप है जिसे वायु सेना पारंपरिक लड़ाकू जेट के अपने बेड़े के लिए एक शक्तिशाली पूरक बनने की उम्मीद करती है। इसका उद्देश्य मानव पायलटों को युद्ध में तैनात करने के लिए अत्यधिक सक्षम रोबोट विंगमैन का झुंड देना है। हालाँकि, Valkyrie स्वायत्त नहीं है। हालाँकि यह दुश्मन के खतरों की पहचान करने और उनका मूल्यांकन करने के लिए AI और सेंसर का उपयोग करेगा, फिर भी यह तय करना पायलटों पर निर्भर होगा कि लक्ष्य पर हमला करना है या नहीं।

पेंटागन के अधिकारी भले ही अभी युद्ध में स्वायत्त हथियारों का इस्तेमाल न कर रहे हों, लेकिन वे ऐसे हथियारों का परीक्षण और सुधार कर रहे हैं जो मानवीय हस्तक्षेप पर निर्भर नहीं होंगे। इसका एक उदाहरण सेना का प्रोजेक्ट कन्वर्जेंस है। अगस्त 2020 में एरिजोना के युमा प्रोविंग ग्राउंड में आयोजित परियोजना के हिस्से के रूप में किए गए एक परीक्षण में, सेना ने नकली दुश्मन बलों को ट्रैक करने के लिए कई तरह के हवाई और ज़मीनी सेंसर का इस्तेमाल किया और फिर वाशिंगटन राज्य के एक बेस पर एआई-सक्षम कंप्यूटर का उपयोग करके उस डेटा को प्रोसेस किया। बदले में, उन कंप्यूटरों ने युमा में ज़मीनी तोपखाने को फायर निर्देश जारी किए। “यह पूरा क्रम कथित तौर पर 20 सेकंड के भीतर पूरा किया गया था,” कांग्रेसनल रिसर्च सर्विस ने बाद में रिपोर्ट की।

रेप्लिकेटर पहल के नाम से जाने जाने वाले अमेरिकी कार्यक्रम में, पेंटागन ने कहा कि उसने हजारों स्वायत्त ड्रोन का बड़े पैमाने पर उत्पादन करने की योजना बनाई है। हालांकि, किसी भी आधिकारिक नीति ने स्वायत्त हथियारों के इस्तेमाल को उचित नहीं ठहराया है, जो उपकरणों को यह तय करने की अनुमति देगा कि किसी व्यक्ति की मंजूरी के बिना किसी लक्ष्य पर हमला करना है या नहीं।

नौसेना के पास प्रोजेक्ट कन्वर्जेंस के बराबर एक AI है जिसे “प्रोजेक्ट ओवरमैच” कहा जाता है। नौसेना संचालन के प्रमुख एडमिरल माइकल गिल्डे के शब्दों में, इसका उद्देश्य “एक ऐसी नौसेना को सक्षम करना है जो समुद्र में घूमती है, निकट और दूर, हर धुरी और हर डोमेन से एक साथ घातक और गैर-घातक प्रभाव डालती है।” परियोजना के बारे में बहुत कम जानकारी सामने आई है।

NSA निदेशक, यूएस साइबर कमांड कमांडर और केंद्रीय सुरक्षा सेवा के प्रमुख के रूप में कार्य करने वाले जनरल टिमोथी हॉग के अनुसार, राष्ट्रीय सुरक्षा एजेंसी (NSA) द्वारा नियोजित लगभग 7,000 विश्लेषक अपने संचालन में AI को एकीकृत करने का प्रयास कर रहे हैं। जनरल हॉग ने खुलासा किया है कि 2024 तक, NSA 170 AI परियोजनाओं में लगा हुआ है, जिनमें से 10 को राष्ट्रीय सुरक्षा के लिए महत्वपूर्ण माना जाता है। वे कहते हैं, “उन अन्य 160 में, हम लोगों को प्रयोग करने, लाभ उठाने और अनुपालनपूर्वक उपयोग करने के अवसर प्रदान करना चाहते हैं।”

हालांकि, वर्तमान में, AI को अभी भी पारंपरिक प्लेटफ़ॉर्म के पूरक के रूप में माना जाता है। AI को चार अतिरिक्त भूमिकाएँ निभाने के रूप में भी देखा जाता है: योजना और रणनीति को स्वचालित करना; मनुष्यों या पारंपरिक प्रणालियों की तुलना में संकेतों को अधिक कुशलता से जोड़ना और व्याख्या करना; अंतरिक्ष-आधारित प्रणालियों की सहायता करना, मुख्य रूप से हाइपरसोनिक्स का मुकाबला करने के लिए जानकारी एकत्र और संश्लेषित करके; और अगली पीढ़ी के साइबर और सूचना युद्ध क्षमताओं को सक्षम करना।

AI उपयोग की नैतिकता

हालाँकि स्वायत्त हथियारों का उपयोग दशकों से बहस का विषय रहा है, लेकिन कुछ पर्यवेक्षकों को उम्मीद है कि कोई अंतर्राष्ट्रीय समझौता नए नियम स्थापित करेगा, खासकर जब अमेरिका, चीन, इज़राइल, रूस और अन्य और भी अधिक उन्नत हथियार विकसित करने की होड़ में हैं।

संयुक्त राष्ट्र में स्वायत्त हथियारों पर ऑस्ट्रिया के शीर्ष वार्ताकार अलेक्जेंडर केमेंट कहते हैं, “भू-राजनीति इसे असंभव बनाती है।” “इन हथियारों का इस्तेमाल किया जाएगा, और इनका इस्तेमाल लगभग सभी के सैन्य शस्त्रागार में किया जाएगा।” ऐसी चुनौतियों के बावजूद, ह्यूमन राइट्स वॉच ने “स्वायत्त हथियार प्रणालियों को प्रतिबंधित करने और विनियमित करने के लिए कानूनी रूप से बाध्यकारी साधन की तत्काल बातचीत और अपनाने” का आह्वान किया है।

इसने हत्यारे रोबोटों को रोकने के लिए अभियान शुरू किया है, जिसके बारे में मानवाधिकार संगठन का कहना है कि इसमें 270 से अधिक समूह और 70 देश शामिल हुए हैं। भले ही विवाद स्वायत्त हथियारों के इर्द-गिर्द केंद्रित रहा हो, लेकिन एआई ड्रोन निर्माता एंडुरिल के सीईओ ब्रायन शिम्पफ का एक अलग दृष्टिकोण है। उनका कहना है कि एआई हथियार “मनुष्यों को लूप से बाहर करने के बारे में नहीं हैं। मुझे नहीं लगता कि यह सही नैतिक ढांचा है। यह वास्तव में इस बारे में है कि हम मानव निर्णयकर्ताओं को उनके निर्णयों के लिए अधिक प्रभावी और अधिक जवाबदेह कैसे बनाते हैं।” वैसे भी, स्वायत्त एआई हथियार पहले से ही विकास के अधीन हैं। जीवन-मरण से जुड़े निर्णय लेने के लिए हथियार पर निर्भर रहने की नैतिकता के अलावा, एआई के साथ भी एक समस्या है।

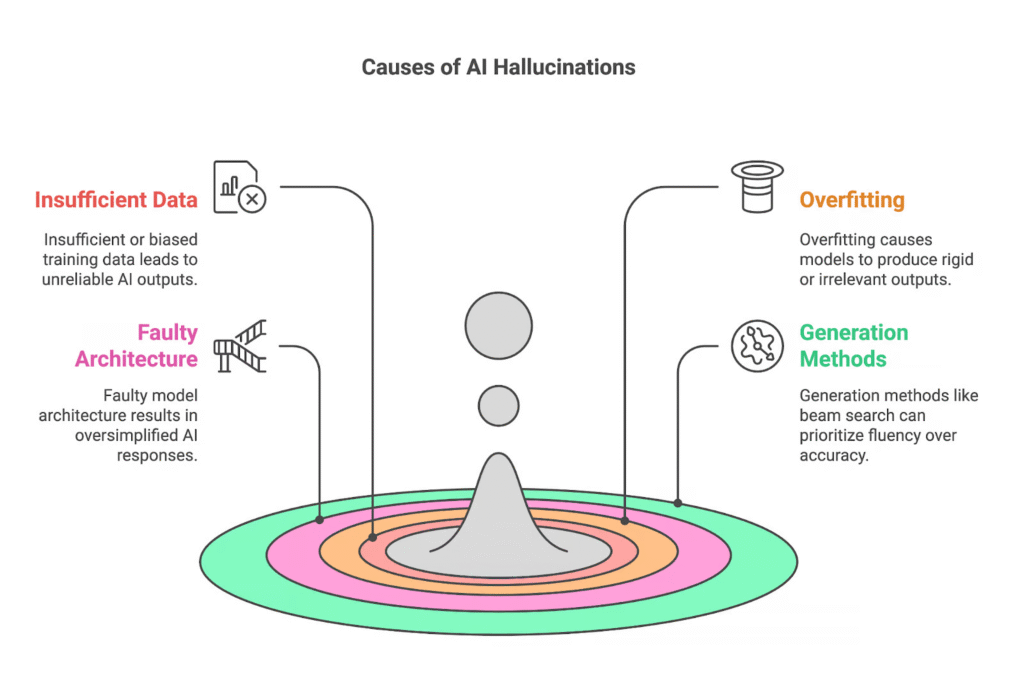

त्रुटियाँ और गलत गणनाएँ अपेक्षाकृत आम हैं। AI सिस्टम के संचालन में अंतर्निहित एल्गोरिदम गलतियाँ करने में सक्षम हैं – “मतिभ्रम” – जिसमें उचित प्रतीत होने वाले परिणाम पूरी तरह से भ्रामक हो जाते हैं। यह AI हथियारों को तैनात करने के लिए गहन निहितार्थ हो सकता है जो मानव ऑपरेटरों द्वारा पता न लगाए जा सकने वाले गहन त्रुटिपूर्ण निर्देशों के साथ काम करते हैं।

एक विशेष रूप से डायस्टोपियन परिदृश्य में, एक विरोधी मानव जनरलों के लिए रोबोट जनरलों को प्रतिस्थापित कर सकता है, जिससे अमेरिका को भी ऐसा करने के लिए मजबूर होना पड़ सकता है, जिसके परिणामस्वरूप AI सिस्टम अप्रत्याशित और संभवतः विनाशकारी परिणामों के साथ युद्ध के मैदान में एक दूसरे के खिलाफ खड़े हो सकते हैं।

लंदन के क्वीन मैरी विश्वविद्यालय की डॉ. एल्के श्वार्ज AI हथियार दुविधा को एक सैद्धांतिक ढांचे के माध्यम से देखती हैं जो युद्ध में AI के नैतिक आयामों पर उनके विचार में राजनीति विज्ञान और अनुभवजन्य जांच पर निर्भर करता है। उनका मानना है कि AI-सक्षम हथियार प्रणालियों का एकीकरण मानव लक्ष्यों के वस्तुकरण की सुविधा प्रदान करता है, जिससे संपार्श्विक क्षति के लिए सहनशीलता बढ़ जाती है। उनके विचार में, स्वचालन “AI-सक्षम लक्ष्यीकरण प्रणालियों के संचालकों के बीच नैतिक एजेंसी को कमज़ोर कर सकता है, जिससे नैतिक निर्णय लेने की उनकी क्षमता कम हो सकती है।” स्वायत्त प्रणालियों के प्रति पूर्वाग्रह रक्षा उद्योग को सैन्य AI प्रणालियों को वित्तपोषित करने के लिए प्रेरित कर सकता है, जिससे “युद्ध में ज़िम्मेदार AI के उपयोग की धारणा प्रभावित हो सकती है।” वह नीति निर्माताओं से बहुत देर होने से पहले जोखिमों को ध्यान में रखने का आग्रह करती हैं।

एरिजोना स्टेट यूनिवर्सिटी के प्रोफेसर और अमेरिकी थिंक टैंक न्यू अमेरिका के रणनीतिकार और वरिष्ठ फेलो पीटर सिंगर कहते हैं, “AI का प्रभाव मशीन गन या विमान से कहीं ज़्यादा है। यह पिछली औद्योगिक क्रांति में मांसपेशियों की शक्ति से मशीन की शक्ति में बदलाव की तरह है।” “मेरा मानना है कि सॉफ़्टवेयर पक्ष पर AI का आगमन और हार्डवेयर पक्ष पर रोबोटिक्स में इसका अनुप्रयोग औद्योगिक क्रांति के बराबर है जब हमने मशीनीकरण देखा।” यह परिवर्तन “सही और गलत के नए सवाल उठाता है, जिनसे हम पहले जूझ नहीं रहे थे।” वह “युद्ध में एआई के उपयोग को नियंत्रित करने के लिए रूपरेखा” स्थापित करने की वकालत करते हैं, जो उन लोगों पर लागू होनी चाहिए जो डिजाइन और उपयोग पर काम कर रहे हैं।

सिंगर ने जिन मुद्दों को “मशीन की अनुमति” कहा है, उनमें से एक यह है कि मशीन को मानवीय नियंत्रण के अलावा क्या करने की अनुमति दी जानी चाहिए। वह दूसरे मुद्दे की ओर ध्यान आकर्षित करते हैं “जिससे हमने पहले कभी निपटा नहीं है,” जो है “मशीन की जवाबदेही।” “अगर कुछ होता है, तो हम किसे ज़िम्मेदार ठहराएँगे अगर यह मशीन ही है जो कार्रवाई करती है? यह समझना बहुत आसान है कि एक नियमित कार के साथ, यह समझना मुश्किल है कि तथाकथित चालक रहित कार के साथ।”

युद्ध के मैदान में, अगर लक्ष्य गलत हो गया या परिणामस्वरूप नागरिक मारे गए तो क्या मशीन को ज़िम्मेदार ठहराया जाएगा?

यह लेख ऑब्ज़र्वेटरी के लिए इंडिपेंडेंट मीडिया इंस्टीट्यूट द्वारा तैयार किया गया था। न्यूज़क्लिक से पुनर्प्रकाशित।