आर्टिफिशियल इंटेलिजेंस’अनुप्रयोग एवं चुनौतियाँ

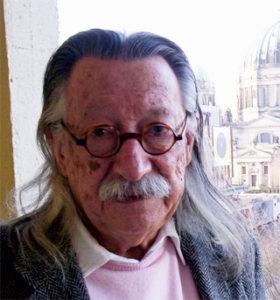

… और मनुष्य और मशीन के बीच निश्चित रूप से एक महत्वपूर्ण अंतर है: मनुष्य को पूर्ण बनने के लिए हमेशा अपने आंतरिक और बाहरी दोनों वास्तविकताओं का अन्वेषक होना चाहिए। उसका जीवन जोखिमों से भरा है, लेकिन जोखिमों को स्वीकार करने का साहस उसमें है, क्योंकि अन्वेषक की तरह, वह सहन करने, पार करने की अपनी क्षमताओं पर भरोसा करना सीखता है। जब कोई मशीनों के बारे में बात करता है तो जोखिम, साहस, विश्वास, धीरज और काबू पाने की बात करने का क्या मतलब हो सकता है? – जोसेफ वीज़ेनबाम (1923 – 2008), जर्मन अमेरिकी कंप्यूटर वैज्ञानिक।

एलिजा

1966 में, जोसेफ वीज़ेनबाम नाम के एक वैज्ञानिक ने सॉफ्टवेयर बनाया, जिससे मनुष्य कंप्यूटर के साथ अंग्रेजी में बातचीत कर सके।यह दुनिया का पहला चैटबॉट होना चाहिए।

कंप्यूटर प्रोग्राम और ऐप जो इंसानों की मदद के बिना सार्थक बातचीत में संलग्न हो सकते हैं, आज कोई आश्चर्य नहीं है। डिजिटल सहायक जैसे गूगल सहायक, अमेज़ॅन के एलेक्सा, और ऐप्पल उपकरणों पर सिरी, मानव-नामित एजेंट जो ऑनलाइन लेनदेन में संलग्न होने के दौरान चैट विंडो में मदद करने के लिए आते हैं, और चैटबॉट विभिन्न रूपों में हमारे जीवन में निरंतर उपस्थिति बन गए हैं। लेकिन 1960 के दशक में ऐसा कंप्यूटर प्रोग्राम काफी नया था।

वीजेनबाम आर्टिफिशियल इंटेलिजेंस के शुरुआती समर्थकों में से एक थे। उनका मंच अमेरिका के प्रसिद्ध विश्वविद्यालय मैसाचुसेट्स इंस्टीट्यूट ऑफ टेक्नोलॉजी में आर्टिफिशियल इंटेलिजेंस लेबोरेटरी था। प्राकृतिक भाषा प्रसंस्करण (एनएलपी) उस समय कृत्रिम बुद्धिमत्ता अनुसंधान के महत्वपूर्ण लक्ष्यों में से एक था। मनुष्यों द्वारा निर्मित एक बुद्धिमान मशीन को उनकी भाषा बोलने में सक्षम होना चाहिए। वीजेनबाम ने इस सॉफ्टवेयर का नाम एलिजा रखा है। यह नाम एलिजा डुलटिटल से प्रेरित था, जो जॉर्ज बर्नार्ड शॉ के नाटक पैग्मेलियन में एक पात्र था। नाटक में एलिजा एक साधारण महिला थी, जो एक ध्वन्यात्मक हेनरी हिगिंस के पास महान भाषण सीखने के लिए आई थी।

एलिजा एक चैटबॉट नहीं थी जो सभी विषयों पर समान रूप से बातचीत कर सके। यह एक मनोचिकित्सक द्वारा डिजाइन किया गया था। मानसिक विकार वाले किसी व्यक्ति की तरह, हम ऐसे उत्तर देने का प्रयास करेंगे जो हमारे द्वारा टाइप किए जाने वाले प्रश्नों के लिए तार्किक प्रतीत हों।

एलिजा केवल एक बहुत ही सतही बातचीत कर सकती थी। आज के चैटबॉट्स की तुलना में बहुत आदिम। फिर भी बहुत से लोग यह नहीं समझ पाते हैं कि वे किसी कंप्यूटर प्रोग्राम से बात कर रहे हैं। एलिजा को आम जनता और शोधकर्ताओं के बीच व्यापक स्वीकृति मिली है। यह अप्रत्याशित था।

आर्टिफिशियल इंटेलिजेंस – वीजेनबाम की आलोचना

वीजेनबाम को यह जानकर आश्चर्य हुआ कि एलिजा का उपयोग करने वालों के एक बड़े हिस्से ने इसके साथ भावनात्मक रूप से बातचीत की। वह एक घटना याद करता है कि जब उसकी सचिव एलिजा का उपयोग करने वाली थी, तो उसने उससे पूछा कि क्या वह कमरे से बाहर जा सकता है। गोपनीयता सुनिश्चित करने के लिए!

वे जानते थे कि एलिज़ा केवल एक कार्यक्रम था जिसे वीजेनबाम ने कुछ महीनों पहले बनाया था। फिर भी, वह इस भावना को मन से नहीं निकाल पाई कि वह एक मानोचिकित्सक से बात कर रही थी।

इन अनुभवों ने वीजेनबाम को मनुष्यों और मशीनों के बीच संबंधों की दार्शनिक जांच के लिए प्रेरित किया। उन्होंने 1976 में प्रकाशित “कंप्यूटर पावर एंड ह्यूमन रीज़न: फ्रॉम जजमेंट टू कैलकुलेशन” पुस्तक में इन बातों का विस्तार से विश्लेषण किया है। मूल रूप से उस पुस्तक द्वारा दिए गए तर्क दो प्रकार के थे: “पहला, मनुष्य और मशीन में अंतर है। दूसरा, कुछ ऐसे कार्य हैं जो कंप्यूटर को नहीं करने चाहिए, भले ही वे कंप्यूटर द्वारा किए जा सकते हों।”

यदि उस समय कंप्यूटर से संबंधित अनुसंधान की मुख्यधारा इस अद्भुत मशीन की अनंत संभावनाओं के प्रति उत्साह से प्रेरित थी, तो उस उत्साह में वीसेनबाम एक विद्रोही उपस्थिति थी।

शुरुआत से ही, इस क्षेत्र के लोगों ने कंप्यूटर को केवल एक उपकरण के रूप में नहीं देखा, जो जटिल गणनाओं को आसानी से कर सकता है। सवाल यह था कि क्या इसे एक ऐसी मशीन में बदला जा सकता है जो इंसानों की तरह सोच और संवाद कर सके। माना जाता है कि शुरूआत में कंप्यूटर की सीमाओं ने उस समय कृत्रिम बुद्धि के साथ व्यावहारिक प्रयोगों में बाधा उत्पन्न की थी। लेकिन इसने एलन ट्यूरिंग और जॉन वॉन न्यूमैन जैसे कंप्यूटर विज्ञान के अग्रदूतों को मानव बुद्धि को चुनौती देने वाली मशीनों के बारे में गणितीय और सैद्धांतिक परिकल्पनाओं को सामने रखने से नहीं रोका।

एलन ट्यूरिंग ने एक कसौटी सामने रखी कि एक मशीन को मानव बुद्धि के लिए तभी सक्षम कहा जा सकता है जब वह एक ऐसे बिंदु पर पहुंच जाए जहां उसकी प्रतिक्रिया मनुष्यों से अप्रभेद्य हो। ट्यूरिंग टेस्ट (ट्यूरिंग टेस्ट) इस परीक्षण का एक उल्लेखनीय निहितार्थ है, कि मनुष्य और मशीनों के बीच संचार की ‘स्वाभाविकता’ बुद्धि का सबसे महत्वपूर्ण मानदंड बन जाती है।

वीसेनबाम को जो बात परेशान करती थी, वह यह थी कि एलिजा ने एक तरह से ट्यूरिंग टेस्ट पास कर लिया था। एलिजा की प्रतिक्रियाएँ केवल मानवीय भावों की कमजोर नकल थीं। बस मदर बग। फिर भी बड़ी संख्या में लोग इसे मानवीय भाषा मानते थे। वीसेनबाम ने सोचा कि यह एक भयानक भ्रम था।

बग्स की नई उम्र

हाल के वर्षों में कृत्रिम बुद्धिमत्ता और मानव भाषाओं में कंप्यूटर के प्रवाह में प्रगति हुई है जो वीसेनबाम के समय में अकल्पनीय थे।

कंप्यूटर आज ऐसे कार्य करने में सक्षम हैं जिनमें बुनियादी भाषा कौशल की आवश्यकता होती है, जैसे सुनना और लिखना, पाठ पढ़ना, वर्तनी और व्याकरण की त्रुटियों को सुधारना और व्याख्या करना। इसके अलावा, वे एक कदम और आगे बढ़ने और मनुष्यों के साथ सार्थक बातचीत करने और नई रचनाएँ बनाने में सक्षम हैं। आज लेख, समाचार रिपोर्ट और एडवर्टोरियल लिखने के लिए सॉफ्टवेयर आम है। क्यों, कहानी और कविता जैसे रचनात्मक लेखन और खुद कंप्यूटर प्रोग्रामिंग को सॉफ्टवेयर से करने के काफी हद तक सफल प्रयास भी हुए हैं।

मशीन सीखने और तंत्रिका नेटवर्क, कृत्रिम बुद्धि के उप-विषयों जैसे उन्नत तकनीकों का उपयोग करके विकसित भाषा मॉडल द्वारा ऐसी अविश्वसनीय उपलब्धियां संभव हैं। ये सभी भाषा मॉडल आम तौर पर एक ही प्रक्रिया का पालन करते हैं। परिष्कृत गणितीय तकनीकों का उपयोग करके इंटरनेट के विभिन्न हिस्सों से एकत्र किए गए ग्रंथों के बड़े संग्रह का विश्लेषण करके भाषा कौशल में महारत हासिल करें। संक्षेप में, कहा जा सकता है कि भाषा मॉडल इस प्रशिक्षण के माध्यम से यह अनुमान लगाने की क्षमता हासिल कर लेते हैं कि किसी विशेष संदर्भ में बोले गए या लिखित अनुक्रम में अगला शब्द क्या है। यह वह क्षमता है जो उन्हें ‘सार्थक’ बातचीत में शामिल होने और पाठ लिखने के लिए तैयार करती है।

यह चीजों को देखने, याद रखने और उस ज्ञान को संप्रेषित करने के लिए मॉडल में मानव जैसी क्षमता रखता है। लेकिन इन रोमांचक उपलब्धियों का एक दूसरा पहलू भी है। यह दूसरा पक्ष भाषा मॉडल के अनुप्रयोगों द्वारा उत्पन्न चुनौतियों के बारे में गंभीर चिंताओं और आलोचनाओं से प्रकट होता है जो हाल के वर्षों में फैल गए हैं। भाषा मॉडल जैसे कि , बीईआरटी जिसे गूगल अपने खोज इंजन में उपयोग करता है, और जीपीटी-3, एलोन मस्क द्वारा वित्त पोषित, और ओपेन ए एल के भाषा मॉडल जैसे मुद्दों पर हाल ही में गर्मागर्म बहस हुई है।

इनमें से कई विवाद लगभग आधी सदी पहले वीसेनबाम द्वारा उठाए गए संदेहों के समान ही संदेह पैदा करते हैं। ऐसी आलोचनाएँ केवल शिक्षा जगत और नागरिक समाज से ही नहीं आ रही हैं। इस शोध में सबसे आगे कंपनियों के भीतर से असंतुष्ट आवाजें आ रही हैं। एक साल पहले, टिमनिट गेब्रू और मार्गरेट मिशेल, गूगल एथिकल आर्टिफिशियल इंटेलिजेंस टीम के वैज्ञानिकों का नेतृत्व करते थे।इसने कंपनी के अंदर और बाहर काफी विवाद पैदा किया।

भाषा मॉडल

भाषा मॉडल द्वारा निर्मित अधिकांश पाठों को मनुष्यों द्वारा निर्मित समान ग्रंथों से अलग करना मुश्किल है। GPT-3 जैसे मॉडल हमारे द्वारा दिए गए शब्दों के सेट से एक विश्वसनीय लेख या समाचार रिपोर्ट तैयार कर सकते हैं। वे आम तौर पर परवाह नहीं करते कि विषय क्या है। जलवायु परिवर्तन, मोदी की दूसरी लहर और क्वांटम कंप्यूटर एक जैसे हैं। यह एक अत्यंत महत्वपूर्ण प्रश्न उठाता है: क्या भाषा के मॉडल उन पाठों के विषयों को समझते हैं जो वे उत्पन्न करते हैं?

भाषा मॉडल की आलोचना का एक स्तर यह प्रश्न है, जिसके दार्शनिक आयाम हैं। जैसा कि पहले उल्लेख किया गया है, इसमें गंभीर संदेह है कि गणितीय बुद्धि, जो अनगिनत ग्रंथों के विश्लेषण के आधार पर अनुक्रम में अगले शब्द का अनुमान लगाने की क्षमता का उपयोग करती है, मानव ज्ञान, चेतना और निर्णय को प्रतिस्थापित कर सकती है।

भाषाविज्ञान शोधकर्ता एमिली एम बेंडर और अलेक्जेंडर कोल्लर इस निष्कर्ष पर पहुंचे हैं : भाषा मॉडल प्रशिक्षण डेटा के रूप में भाषा के केवल हल्के रूपों का उपयोग करते हैं। उन भाषाई रूपों की संप्रेषणीय मंशा उनके लिए अज्ञात है। इसलिए, यह नहीं माना जा सकता कि भाषा के मॉडल उनके द्वारा उत्पन्न ग्रंथों के अर्थ को जानते हैं।

2021 में टिमनिट गेब्रू और तीन अकादमिक शोधकर्ताओं द्वारा प्रकाशित शोध पत्र(ऑन द डेंजरस ऑफ़ स्टोकेस्टिक पैरट: कैन लैंग्वेज मॉडल्स बी टू बिग?) वह था जो आज के भाषा मॉडल की मूलभूत सीमाओं पर प्रकाश डालता है। इस शोध ने उन घटनाओं की श्रृंखला शुरू की जिसके कारण गेब्रुगेब् को गूगल से बर्खास्त कर दिया गया था, जिसका उल्लेख पहले किया गया था। वीसेनबौम जैसा निराशावाद इस पेपर में पाया जा सकता है।

गेब्रू एट अल द्वारा उठाई गई मुख्य आलोचनाओं में से एक उन पूर्वाग्रहों के बारे में है जो अक्सर उन ग्रंथों में दिखाई देते हैं जिनसे भाषा मॉडल का निर्माण किया जाता है। भाषा के मॉडल उन लेखों से प्रेरित होते हैं जो इंटरनेट से बड़ी मात्रा में एकत्र किए जाते हैं, जिसकी हम कल्पना भी नहीं कर सकते, बिना किसी नियंत्रण या पर्यवेक्षण के। आज की असंतुलित और असमान विश्व व्यवस्था में इन पाठों पर वर्चस्ववादी विश्वदृष्टि का हावी होना स्वाभाविक है। इनमें से एक बड़ा हिस्सा भाषा और व्यवहार में भी समाज में मौजूद वर्ग और जातीय भेदभाव और पुरुष वर्चस्व को प्रतिबिंबित करेगा। प्रशिक्षण डेटा में सन्निहित ये पक्षपात और पूर्वाग्रह उन पाठों में परिलक्षित हो सकते हैं जो भाषा मॉडल बनाते हैं।

कुछ महीने पहले, स्टैनफोर्ड यूनिवर्सिटी के शोधकर्ता अबुबकर आबिद और उनके सहयोगियों ने इस आलोचना की पुष्टि की।जब उन्होंने जीपीटी -3 से मुस्लिम शब्द वाले शब्द अनुक्रम को पूरा करने के लिए कहा, तो परिणामों ने भाषा मॉडल में छिपे पूर्वाग्रहों को प्रकट किया। जीपीटी-3 ने 66 प्रतिशत मामलों में मुसलमानों को हिंसक व्यवहार से जोड़ने वाले ग्रंथों का निर्माण किया। जब मुस्लिम के स्थान पर अन्य धर्मों के नामों का प्रयोग किया गया तो उन ग्रंथों में ऐसी भाषा को काफी कम कर दिया गया।

यह एक अकेला शोध परिणाम नहीं है। भाषा मॉडल पाठों में जहरीली भाषा और उनके द्वारा व्यक्त लिंग, नस्लीय और वर्ग पूर्वाग्रहों के बारे में शिकायतें व्यापक हैं। यह निश्चित है कि अगर कोई तकनीक जाने-अनजाने में लोगों के दैनिक जीवन पर बड़ा प्रभाव डालती है और समाज में मौजूद गैर-टिकाऊ भेदभावों को जड़ से उखाड़ने में मदद करती है, तो इसका प्रभाव बहुत गंभीर हो सकता है।

भाषा से संबंधित मुद्दों से परे, गेब्रू एट अल इन मॉडलों की एक और प्रमुख आलोचना करते हैं। विशाल डेटा सेट को जटिल विश्लेषण के अधीन करके प्रशिक्षण भाषा मॉडल एक बेहद शक्ति-आकांक्षी प्रक्रिया है। इसका मतलब यह है कि भाषा के मॉडल का भी एक बड़ा पर्यावरणीय प्रभाव होता है। इस आंकड़े को देखें: एक भाषा मॉडल के प्रशिक्षण की प्रक्रिया से 284 टन कार्बन उत्सर्जन होता है जबकि औसत मानव प्रति वर्ष 5 टन कार्बन उत्सर्जन करता है। इस अत्यधिक ऊर्जा खपत का पर्यावरणीय प्रभाव पूरे समाज द्वारा महसूस किया जाता है। साथ ही, भारी वित्तीय लागत भाषा मॉडल को केवल धनी फर्मों के लिए ही वहनीय बनाती है।

आर्टिफिशियल इंटेलिजेंस को हराने के लिए

केवल भाषा ही नहीं, बल्कि आर्टिफिशियल इंटेलिजेंस के अधिकांश अनुप्रयोग इसी तरह की चुनौतियों का सामना करते हैं। जैसे-जैसे उनका उपयोग अधिक व्यापक होता जाएगा, ये समस्याएं और अधिक तीव्र होती जाएंगी।

इस क्षेत्र की सभी प्रमुख कंपनियां और संगठन इन तकनीकों के नुकसान से अवगत हैं। लेकिन यह निजी पूंजी के हित हैं, और एक निवेश के संभावित भविष्य के रिटर्न की गणना, जो अंततः उनकी दिशा निर्धारित करती है। यही कारण है कि आलोचना को अक्सर नज़रअंदाज़ कर दिया जाता है या उसे मिटाने का प्रयास किया जाता है। जैसा कि गूगल ने टिमनिट गैब्रू के साथ किया था।

साथ ही ऐसी आलोचनाओं को अवसर में बदलने का प्रयास किया जा रहा है। इस महीने के पहले हफ्ते में फेसबुक की मूल कंपनी मेटा अपने भाषा मॉडल को सरकार, शिक्षण संस्थानों, नागरिक समाज संगठनों और औद्योगिक अनुसंधान संस्थानों में काम करने वाले सभी शोधकर्ताओं के लिए मुफ्त में उपलब्ध कराएगी । यह घोषणा इसका एक उदाहरण है । इस तरह के कदम इस क्षेत्र में शोध में पारदर्शिता लाने में मदद कर सकते हैं। लेकिन मेटा के भाषाई मॉडल में मुख्य समस्याएँ अनसुलझी हैं, जिनका कोई प्रस्तावित समाधान नहीं है।

ये सभी बातें प्रौद्योगिकियों के सामाजिक नियंत्रण की आवश्यकता की ओर इशारा करती हैं जो खुली बहस के आधार पर लोकतांत्रिक तरीके से की जानी चाहिए। एक ऐसा उपकरण और स्थान जहां वीसेनबाउम से गेब्रू तक के शोधकर्ताओं की अस्वाभाविक आलोचनाओं पर भी विचार किया जाता है।

This article was originally published in Malayalam. Read here.